A Historia da Ciência do Clima

Introdução

O fato do dióxido de carbono ser um “gás de efeito estufa” - um gás que impede que certa quantia de radiação na forma de calor escape da atmosfera de volta ao espaço, e assim mantenha um clima relativamente quente na Terra - remonta a uma ideia que foi inicialmente concebida, apesar de não especificamente para o CO2, quase 200 anos atrás. A história de como esta importante propriedade física foi descoberta, como seu papel no passado geológico foi estimado e como nós viemos a entender que sua concentração crescente, pela queima de combustíveis fósseis, causaria efeitos adversos no nosso futuro, cobre aproximadamente dois séculos de pesquisa, descobertas, inovações e resolução de problemas.

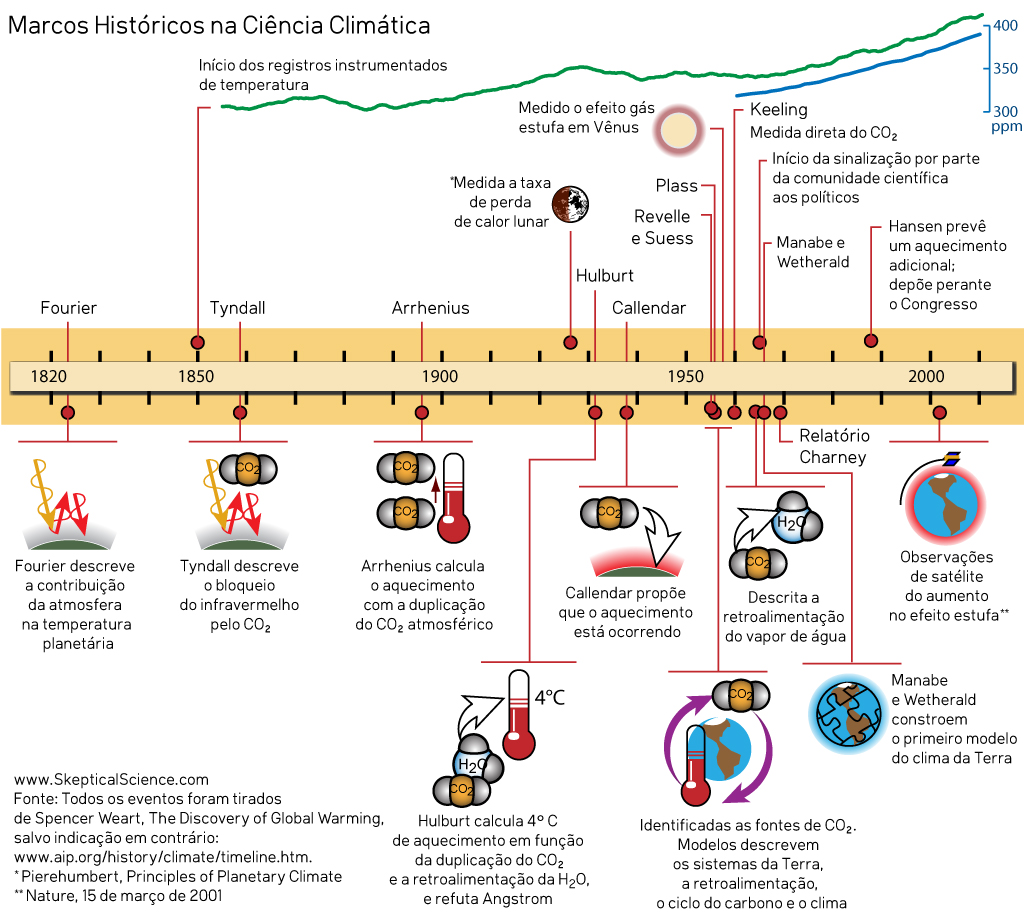

Ciência Climática - a linha do tempo completa - criada por jg

Ciência Climática - a linha do tempo completa - criada por jg

No Início...

Para entendermos o contexto científico do que atualmente é conhecido como Efeito Estufa, temos que viajar de volta no tempo, à França dos anos 1820. Napoleão, derrotado na Batalha de Waterloo há poucos anos, recém tinha falecido, mas certa pessoa que antes havia assumido significantes projetos acadêmicos e de engenharia para o último Imperador estava agora engajado arduamente em suas investigações do mundo físico, com interesse específico no comportamento do calor. Este era Jean Baptiste Joseph Fourier (1768-1830).

Fourier havia calculado que um objeto planetário do tamanho da Terra não deveria ser tão quente pois estava a uma distância muito grande do Sol. Assim, ele raciocinou, deveria existir algo mais além da radiação solar incidente, algum outro fator que manteria o planeta aquecido. Uma ideia que lhe veio à mente foi que a energia oriunda do sol na forma de luz visível e ultravioleta (conhecida na época como “calor luminoso”) seria facilmente capaz de passar pela atmosfera da Terra e aquecer a superfície do planeta, mas que o “calor não luminoso” (atualmente conhecido como radiação infravermelho) então emitido pela superfície da Terra não seria capaz de fazer o trajeto inverso tão rapidamente. Ele raciocionou que o ar quente deveria agir como um cobertor isolante, e isso foi o mais longe que a ideia foi na época, visto que as medições detalhadas necessárias para se explorar esta hipótese não estavam disponíveis devido à tecnologia então existente.

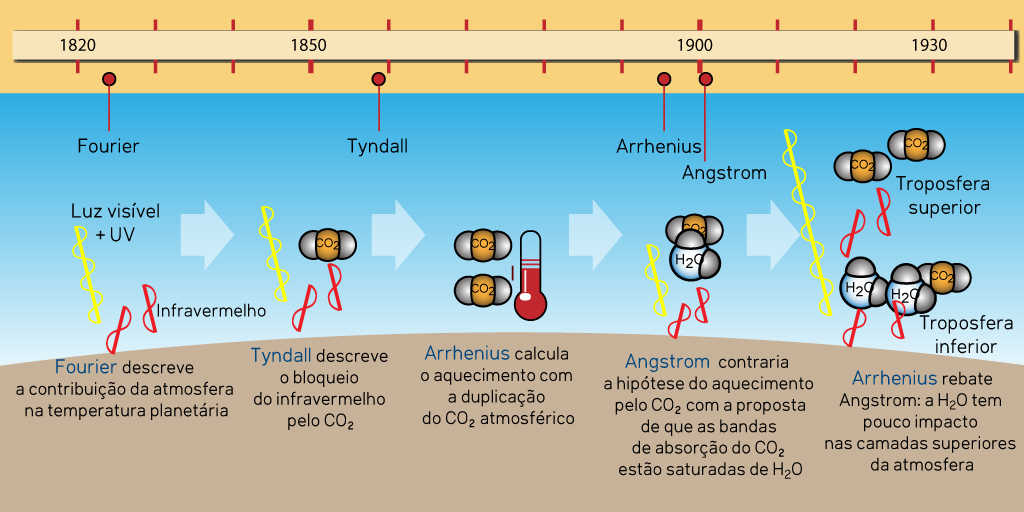

Linha do tempo da Ciência Climática, 1820-1930, criada por jg

Linha do tempo da Ciência Climática, 1820-1930, criada por jg

Anos 1860: Tyndall e os gases que retêm calor

Quarenta anos mais tarde, a questão foi retomada. Para o pioneiro em montanhismo Alpino e historiador natural vitoriano John Tyndall (1820-1893), a evidência (hoje plenamente aceita, mas controversa naquele tempo) claramente indicava que em algum momento parte significativa do nordeste europeu havia sido coberto por mantos de gelo. No entanto o que estava longe de se entender era como o clima poderia mudar de modo tão brusco. Entre as possibilidades que Tyndall considerou estavam as variações na composição da atmosfera. Por meio de uma série de experimentos ele descobriu que o vapor d’água era um importante gás retentor de calor. Ele observou, ainda, que o dióxido de carbono também era muito efetivo em reter calor, apesar de ser um gás traço (ocorrer na faixa de centenas de partes por milhão - ppm). Centenas de partes por milhão podem não parecer muita coisa, mas alguns compostos têm propriedades importantes nessas concentrações: por exemplo, 500 ppm de sulfeto de hidrogênio no ar podem levar à asfixia, como qualquer guia de segurança sobre o gás pode confirmar.

Dióxido de carbono: Arrhenius faz uma descoberta

A descoberta interessante de Tyndall não resolveu completamente o enigma das idades do gelo: isso aconteceu muito tempo depois. No entanto, foi o suficiente para plantar uma semente de ideia que foi reanalisada no final do século XIX pelo cientista sueco Svante Arrhenius (1859-1927). Como o vapor d’água oscilava diariamente e estava frequentemente indo e voltando na atmosfera, Arrhenius focou sua atenção ao dióxido de carbono, um gás de longa permanência na atmosfera, cuja concentração havia sido dramaticamente alterada, até então, apenas por grandes emissores, como vulcões, ou sumidouros, como episódios massivos de intemperismo de minerais ou evolução de plantas fotossintéticas; eventos que ocorrem em uma escala de tempo muito longa, geológica. Arrhenius percebeu que um aumento na quantidade de dióxido de carbono na atmosfera resultaria em uma certa quantidade de aquecimento da mesma. Adicionalmente, já se sabia, pela relação Clausius-Clapeyron, que o ar mais quente é capaz de manter mais vapor d’água: 7% mais por grau celsius de aquecimento. E este vapor d’água adicional, por sua vez, causaria posterior aquecimento - sendo este o efeito de retroalimentação (feedback) positivo, no qual o dióxido de carbono age como um regulador direto da temperatura, sendo então auxiliado pelo vapor d’água adicional retido na atmosfera conforme a temperatura sobe.

Em estudos posteriores, Arrhenius determinou que se a concentração atmosférica de dióxido de carbono fosse reduzida pela metade, as temperaturas na Europa poderiam cair entre 4-5°C. Mas seria possível que uma mudança como essa, grande o suficiente para iniciar uma idade do gelo, ocorresse? Ele recorreu ao colega Arvid Hogbom (1857-1940), que estava investigando os ciclos naturais do carbono, para descobrir se isso seria possível. Na época, Hogbom havia começado a considerar as emissões de dióxido de carbono de fábricas (simples o bastante, ao se saber, por exemplo, quantas toneladas de carvão cada fábrica queima por ano). Ele foi surpreendido ao descobrir que as emissões antrópicas eram muito similares às ocorrentes na natureza. Lá nos anos 1890, isso obviamente representava uma pequena fração da quantidade de combustíveis fósseis que queimamos hoje; no entanto, eles se perguntaram o que poderia acontecer se a humanidade queimasse quantidades cada vez maiores de combustíveis fósseis ao longo dos séculos? Deixando de lado a pesquisa sobre idades do gelo, Arrhenius realizou cálculos para ver o que poderia acontecer nas temperaturas se a quantidade de dióxido de carbono na atmosfera fosse duplicada. Ele chegou a um panorama de aquecimento de 5-6°C como média global.

Considerando as taxas de queima de combustíveis fósseis da época, eles não viram isso como um problema: primeiro porque, com essas taxas, levaria milhares de anos para ocorrer a duplicação do dióxido de carbono na atmosfera; e, segundo, porque se acreditava que os oceanos seriam capazes de absorver cinco sextos dessas emissões. Quando a hipótese apareceu em um livro popular publicado em 1908, a taxa de queima de combustíveis fósseis já havia crescido significativamente, de modo que eles revisaram o tempo de duplicação do dióxido de carbono, reduzindo-o para alguns séculos. No entanto, o assunto continuou sendo debatido apenas como uma curiosidade científica, o tipo de conversa descontraída pós-jantar em uma noite qualquer.

Os padrinhos da Ciência Climática

Ceticismo: Arrhenius vs. Ångström

As descobertas foram alvo de muito ceticismo durante o início do século XX: as objeções eram centradas principalmente em alegações de simplificação demasiada, falhas na quantificação das mudanças na nebulosidade e também devido a resultados de laboratório obtidos por outro sueco, Knut Ångström (1857-1910). Ångström instruiu um assistente de laboratório a medir a passagem da radiação infravermelha através de um tubo contendo dióxido de carbono. Os testes iniciaram com concentrações de dióxido de carbono ligeiramente inferiores das que seriam observadas em uma seção completa da atmosfera, do topo para a base - apesar de que, para representar a atmosfera com maior precisão, seria mais adequado um tubo de 250 cm em contraste ao de 30 cm utilizado no experimento. Após essa medição, a quantidade de dióxido de carbono foi reduzida para um terço. Eles observaram o que consideraram uma variação irrelevante nas medições, e chegaram a conclusão de que as bandas de absorção do espectro de luz no qual o dióxido de carbono absorve radiação haviam sido rapidamente saturadas - "entupidas", de modo que sua absorção não aumentaria mais.

Outro problema levantado na época foi que o vapor d’água também absorve radiação infravermelha, e nos espectrógrafos de baixa resolução existentes na época, as bandas de absorção dos dois gases se sobrepunham. Se pensou, então, que o aumento no dióxido de carbono seria balanceado pela sua incapacidade de absorver radiação infravermelha nas bandas do espectro que já estavam sendo bloqueadas pelo vapor d’água, muito mais abundante.

No entanto, alguns anos adiante, muitas críticas já haviam sido feitas em relação à precisão das medidas obtidas por Ångström: acompanhado da redução de 33% nas concentrações de dióxido de carbono, ele havia medido uma redução da absorção da radiação de 0,4%, quando na verdade esta teria sido próxima a 1%, suficiente para causar uma mudança significativa nas temperaturas planetárias.

Na época, no entanto, a conclusão foi que Arrhenius estava errado. Ångström seguiu para outras pesquisas, mesmo após Arrhenius ter publicado um artigo criticando os experimentos e explicando como nas camadas superiores da atmosfera, secas, o papel do vapor d’água era de importância limitada. Isso ocorria - e ainda ocorre - pois o vapor d’água na troposfera superior existe em concentrações várias ordens de magnitude menores que na troposfera inferior, onde a maioria dos efeitos climáticos ocorre. Por azar, entretanto, ninguém realmente prestou atenção nisso, de forma que a hipótese do dióxido de carbono como contribuinte no efeito estufa ficou dormente por mais de duas décadas.

1930s: Hulburt e Callendar

O efeito foi novamente estudado em 1931 quando o físico americano E.O. Hulburt realizou cálculos para determinar o efeito da duplicação do dióxido de carbono mais uma vez, e, incluindo o vapor d’água, chegou a um resultado de aproximadamente 4°C de aquecimento. Ele também refutou o trabalho de Ångström e determinou que, apesar dos processos convectivos, o escape da radiação infravermelha para o espaço (ou o impedimento desse processo) é que era realmente importante. O artigo resultante foi publicado no periódico Physical Review, que não era costumeiramente lido por cientistas atmosféricos e da terra, e assim, consequentemente, não atingiu muitos destes. De qualquer modo, era senso comum que o sistema climático da Terra mantinha-se em algum tipo de equilíbrio natural. Em retrospecto, dadas as mudanças dramáticas no clima que levaram às idades do gelo, este é uma posição curiosa a se tomar.

Sete anos mais tarde o engenheiro inglês Guy Callendar, de certo modo um forasteiro (um especialista em motores a vapor mas com um interesse muito aguçado pela meteorologia), reviveu a ideia, descobrindo evidências de uma tendência de aquecimento no início do século XIX a partir de compilação de registros de temperatura. A longo prazo, os níveis reais de dióxido de carbono na atmosfera foram revistos: Callendar descobriu que as concentrações subiram aproximadamente 10%, o que, ele sugeriu, poderia ter causado o aquecimento. Ainda, sugeriu que para os próximos séculos poderia haver uma mudança no clima, para um estado permanente de aquecimento.

A reação na época foi amena: dúvidas foram lançadas sobre a precisão das medições de dióxido de carbono no século XIX. Além disso, ainda haviam antigas dúvidas sobre o trabalho original de Arrhenius: certamente a imensidão dos oceanos daria um jeito de absorver a maior parte deste gás extra. Callendar sugeriu que a camada superior do oceano, que interage com a atmosfera, se saturaria facilmente com o dióxido de carbono e que isso afetaria sua habilidade de absorver mais, porque, ele pensou, a taxa de mistura das águas rasas e profundas era muito lenta. E ainda havia aquele antigo problema das bandas de absorção de radiação do vapor d’água e do dióxido de carbono que se sobrepunham, reduzindo as propriedades de efeito estufa deste último. Os próprios cálculos de Callendar, considerando um aumento de 2°C na temperatura devido à duplicação do dióxido de carbono na atmosfera, foram muito criticados: uma das maiores críticas foi de que estes cálculos lidavam apenas com a radiação e deixavam de fora efeitos de outro meio importante pelo qual o calor é circulado, a convecção (apesar do que Hulburt já havia escrito). Novamente a ideia de que o aquecimento geraria mais nebulosidade foi levantado - algo que não havia como quantificar devido a ausência de métodos adequados na época. Todas estas dúvidas eram perfeitamente razoáveis, visto que não haviam dados suficientes para clarificá-las.

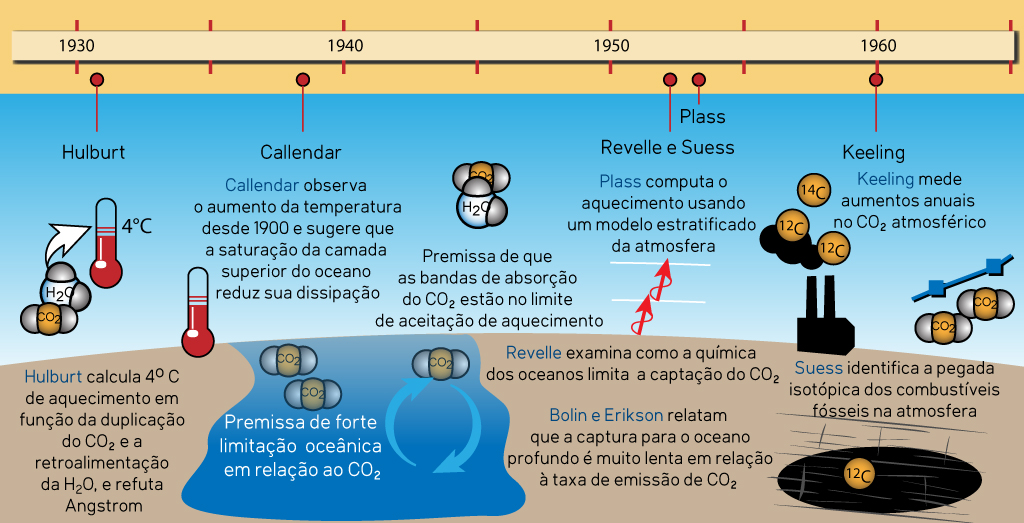

Linha do tempo da Ciência do Clima, 1930-1960, criada por jg

Linha do tempo da Ciência do Clima, 1930-1960, criada por jg

Pós-1945: a tecnologia da Guerra Fria dá uma mão

No período pós-Segunda Guerra Mundial houve um impulso renovado no sentido de desvendar parte do problema climático, favorecido pelo aumento da pesquisa científica que acompanhou o início da Guerra Fria. Os processos atmosféricos tiveram implicações importantes em termos militares, de modo que considerou-se necessário compreendê-los o mais minuciosamente possível, e as propriedades e o comportamento da radiação infravermelha foram submetidos a um escrutínio particular, dado que, se os mísseis pudessem, de alguma forma, buscar pontos quentes tais como a exaustão dos aviões de caça, eles poderiam procura-los e destrui-los. As experiências de Ångström, envolvendo ar com diferentes quantidades de dióxido de carbono em um tubo se mostraram falsas: as diferenças eram muito pequenas para a resolução do equipamento de medição disponível na época. Em vez de amplas bandas de absorção, o equipamento moderno mais preciso encontrou grupos de linhas finas, onde a absorção ocorreria, com lacunas entre as quais o infravermelho passaria sem obstáculos. O dióxido de carbono e o vapor de água tiveram seus próprios conjuntos de linhas de absorção que não coincidiam exatamente, reafirmando que o vapor de água tinha pouca importância nas camadas superiores da atmosfera. Agora, certamente se percebeu que as propriedades de cada camada também precisavam ser levadas em consideração. Hulburt e Callendar – e, inclusive, Arrhenius – estavam no caminho certo, mesmo que aspectos de suas conclusões estivessem incorretos.

Em meados da década de 1950, os cientistas tinham a enorme vantagem do poder de cálculo dos computadores. Isso possibilitou dissecar cada camada de atmosfera da Terra e descobrir como elas poderiam absorver a radiação infravermelha. O físico Gilbert Plass assumiu a tarefa: em primeiro lugar, seu trabalho (artigo publicado com o título The Carbon Dioxide Theory of Climatic Change, no jornal Tellus, em 1956) confirmou que o aumento do dióxido de carbono teria um efeito de aquecimento na atmosfera, e, em segundo lugar, que a duplicação nos níveis desse gás resultaria em um aquecimento de 3-4°C. Isso significaria um aumento de cerca de 1,1°C por século às taxas de emissões de meados dos anos 50. Plass escreveu que, se no final do século XX a temperatura média continuasse a aumentar, ficaria "estabelecido claramente" que o dióxido de carbono poderia causar alterações climáticas. Mas, novamente, a resposta foi tépida. A falta de atenção ao vapor de água e à nebulosidade levaram a críticas ásperas e, novamente, a questão do oceano absorvendo o gás extra foi levantada em objeção à sugestão de Plass de que o dióxido de carbono extra permaneceria na atmosfera por mil anos.

Isótopos de Carbono

A década de 1950 foi a era dos testes nucleares. Entre as partículas emitidas pelas explosões nucleares estava o carbono 14, um isótopo instável do carbono com seis prótons e oito nêutrons no núcleo de seus átomos (o isótopo mais abundante, formando 98,9% de todo o carbono na Terra, é o carbono 12, com seis prótons e seis nêutrons). Como o carbono 14 é instável, sofre decaimento radioativo, e através dessa radioatividade pode ser rastreado à medida que se desloca na atmosfera. O rastreamento permitiu aos cientistas estabelecer que, em questão de anos, todos os gases de longa duração adicionados à atmosfera estariam misturados em todas as camadas, de polo a polo. Mas o carbono 14 também se forma nas camadas superiores da atmosfera, onde ocorre o bombardeamento de raios cósmicos. Este é um processo constante em comparação com os eventos isolados de cada explosão nuclear, um fator que permitiu que mais um teste fosse realizado.

O carbono 14 tem uma meia-vida curta, razão pela qual a datação por radiocarbono é usada apenas para obter a idade de coisas relativamente recentes e não de coisas antigas como rochas com milhões de anos, entre as quais podemos considerar os combustíveis fósseis. No carvão e no petróleo, todo o carbono 14 desapareceu há muito tempo, de modo que queimá-los só liberaria carbono 12 não-radioativo e o carbono 13 mais raro, porém estável. A queima de combustíveis fósseis em grande escala, portanto, adicionaria mais carbono 12 e 13 ao ar em relação ao carbono 14, independentemente dos testes nucleares. O químico Hans Suess colocou isso em um teste para examinar os isótopos de carbono nas árvores. Ele descobriu que quanto mais jovem fosse a madeira, maior a quantidade de carbono 12 e 13 ela teria em relação ao 14. Essa era a impressão digital da queima dos combustíveis fósseis, impressa na madeira.

Suess e Revelle trabalham para esclarecer o papel dos oceanos

Nessa época, o aumento no carbono 12 e 13 era pequeno, reforçando a ideia de que os oceanos estavam absorvendo boa parte do dióxido de carbono adicionado. Pesquisas posteriores realizadas por Suess em parceria com Roger Revelle no Instituto Scripps de Oceanografia, bem como por outros especialistas, chegaram às mesmas conclusões: de que o oceano absorveria cada molécula de dióxido de carbono emitida à atmosfera em aproximadamente uma década. No entanto, Revelle, especialista em química da água do mar, estava ciente de que os compostos químicos presentes nesta têm efeito tamponante que mantem a mesma em um estado levemente alcalino. Revelle sugeriu que o tamponamento imporia limites restritos à quantidade de dióxido de carbono que os oceanos poderiam de fato absorver.

Essa foi uma etapa crítica nas pesquisas. Considerando as taxas de emissões da época (assumindo, como a maioria de seus predecessores, que estas provavelmente permaneceriam constantes), Revelle calculou que, ao longo do tempo, um aumento nos níveis de dióxido de carbono atmosférico de cerca de 40% seria possível nos próximos séculos. No entanto, adicionalmente, ele notou que, se as taxas de emissão continuassem aumentando, o resultado seria diferente, com um aquecimento significativo nas décadas futuras. Sobretudo, ele ressaltou que os seres humanos estavam realizando um experimento geofísico em grande escala que não poderia ter acontecido no passado ou ser reproduzido no futuro - uma alusão, talvez, ao uso crescente dos combustíveis fósseis, finitos e de natureza única, como um recurso não renovável em escala humana.

A capacidade limitada dos oceanos de absorver o dióxido de carbono capturado depois de um tempo foi definida pelos meteorologistas suecos Bert Bolin e Erik Eriksson, que explicaram como isso acontecia. Basicamente, embora o gás seja facilmente absorvido pela água do mar, é o tempo que importa: a mistura das águas oceânicas superficiais e profundas pode levar centenas a milhares de anos, mas a água do mar pode perder parte de sua carga de dióxido de carbono em períodos muito mais curtos. Tal como seus predecessores, Bolin e Eriksson rodaram cálculos relativos à possíveis mudanças na temperatura em função da duplicação do dióxido de carbono, mas desta vez assumindo que as emissões aumentariam ainda mais e em uma taxa ainda mais rápida. Eles escreveram sobre um aumento de 25% do dióxido de carbono atmosférico até o ano 2000. Isso era muito mais drástico do que qualquer coisa sugerida anteriormente, e Bolin advertiu que uma mudança radical no clima poderia ocorrer, uma declaração ecoada pelo climatologista russo Mikhael Budyko em 1962.

Final de 1950: o monitoramento cuidadoso do dióxido de carbono começa

Então, o que estava acontecendo com o conteúdo de dióxido de carbono na atmosfera? Ele estava realmente aumentando? A única maneira de descobrir seria começar a monitorar os níveis do gás através de medições mais precisas. Vários movimentos foram feitos nesse sentido, começando com uma rede de 15 estações de medição na Escandinávia. Os resultados foram incrivelmente ruidosos, e falhas foram encontradas na metodologia. No entanto, na Califórnia, o pesquisador Charles David Keeling melhorou as técnicas até o ponto em que ele sentiu que seria possível isolar e remover as fontes espúrias de ruídos. Revelle e Suess contrataram-no, financiando seu tempo e equipamento. Foram selecionados locais distantes de fontes de dióxido de carbono natural ou produzido pelo homem e de ruídos, em lugares como a Antártica e o topo do vulcão Mauna Loa, no Havaí. Cabe salientar que, no último local, os ventos predominantes sopram do oceano e as fissuras que emitem gases estão quase sempre a favor do vento: se o vento muda, os picos repentinos no registro, causados pelo dióxido de carbono de origem vulcânica são tão evidentes que podem ser facilmente identificados e removidos. De qualquer forma, a idéia era estabelecer uma linha de base mundial para comparar com os níveis de dióxido de carbono nos anos subseqüentes. Em 1958, Keeling estava confiante por ter obtido uma linha de base segura e, dois anos depois ele relatou que os níveis estavam aumentando a uma taxa que só poderia ser esperada se os oceanos não absorvessem a maioria das emissões, conforme mencionado anteriormente.

Níveis de dióxido de carbon atmosférico do final da década de 1950 em diante. Linha vermelha indica as variações sazonais na absorção das plantas.

Infelizmente, as estações da Antártica foram vítimas de falta de financiamento. No entanto, o monitoramento na estação de Mauna Loa se manteve, e continouou observando um aumento nas concentrações de CO2. As medidas também incluíram um ciclo de flutuação bem definido e regular, correspondente às estações de crescimento das plantas no hemisfério norte. Houve uma diminuição na Primavera e no Verão e um aumento no Outono e no Inverno correspondente ao aumento e diminuição na absorção de dióxido de carbono, respectivamente. Entretanto, uma compreensão cada vez maior de outros aspectos do complexo ciclo do carbono estava em andamento. O objetivo geral foi determinar o quanto do dióxido de carbono resultante da queima de combustíveis fósseis estava indo parar nos oceanos, na vegetação, nos solos, nos minerais e assim por diante. Um ponto importante é que este trabalho multidisciplinar finalmente reuniu os vários ramos da ciência que anteriormente trabalhavam isoladamente: meteorologistas, biólogos, geoquímicos, especialistas em informática e assim por diante. Em 1965, foi anunciado que: "até o ano 2000 o aumento do CO2 atmosférico ... pode ser suficiente para produzir mudanças mensuráveis e talvez marcantes no clima".

Meados de 1960: o primeiro Modelo Climático – Mannabe e Wetherald

Em 1967, o primeiro modelo computacional simulando o clima do planeta inteiro foi desenvolvido por Syukuro Manabe, trabalhando em parceria com Richard Wetherald. Esse modelo pode ter sido relativamente básico se comparado aos modelos modernos, no entanto os pesquisadores conseguiram descobrir que o movimento do calor através da convecção impedia que a temperatura alcançasse níveis extremos. Porém, se a quantidade de CO2 dobrasse, a temperatura aumentaria em cerca de 2°C. As correntes de convecção ascendentes, assim como aquelas que podem levar à formação de tempestades, transportam muito calor da superfície da Terra para a troposfera superior: uma superfície quente intensifica esse processo, de forma que cada vez mais calor é elevado e encontra caminhos para os níveis onde ele pode ser reirradiado para o espaço. Se a superfície se tornar mais quente, a convecção levará mais calor para cima. Esse importante controle adicional abordou um problema de longa data que poucos pesquisadores, exceto Hulburt, examinaram em profundidade.

1970: Nova idade do gelo? Não!

A despeito de tais avanços, muitas dúvidas ainda existiam na comunidade científica: o climatologista Helmut Landsberg comentou em 1970 que o aumento do CO2 nas taxas da época poderia levar a um aumento de 2°C na temperatura nos próximos quatro séculos. Ele pensou, no entanto, que isso “dificilmente poderia ser chamado de cataclisma”. Também foi apontado pelo climatologista Hubert Lamb, entre outros, que as incertezas não permitiam explicar as flutuações nas temperaturas dos séculos anteriores, conhecidas a partir de dados históricos. Além disso, a temperatura tinha diminuído um pouco desde 1940, apesar dos níveis de dióxido de carbono terem aumentado. O que isso significava? S. Ichtiaque Rasool e Stephen Schneider da NASA, por exemplo, modelaram os efeitos da poluição na forma de aerossóis e emissões de enxofre na atmosfera e descobriram que um aumento significativo desse tipo de poluição poderia – possivelmente – levar a episódios de resfriamento. Tais achados levaram até alguns cientistas e um grande número de comentaristas a questionar se o período interglacial estava chegando ao fim. Estávamos prestes a entrar em uma nova idade do gelo? A mídia adorou isso: apesar de ser uma visão minoritária, era tão legal e dramático que tomou conta das manchetes.

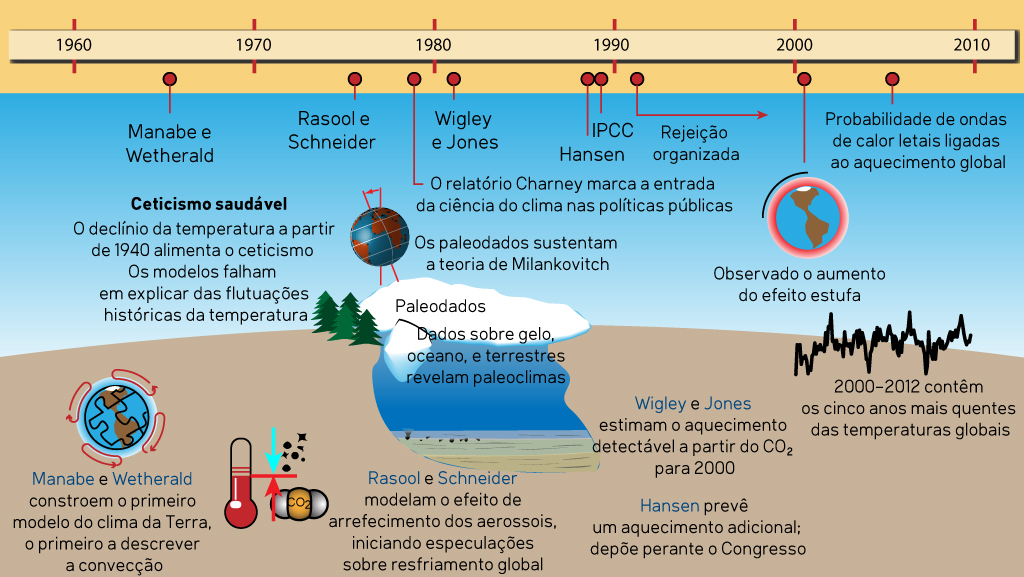

Linha do tempo da ciência do clima, 1960-2010, criado por jg

Linha do tempo da ciência do clima, 1960-2010, criado por jg

Havia apenas uma maneira de descobrir as respostas sobre o que realmente estava acontecendo: continuar com as pesquisas. Durante as décadas de 1970 e 1980, houve outros acontecimentos importantes, que coincidiram com a retomada do aquecimento desde meados dos anos 70. A identificação de outros gases de efeito estufa, por vezes mais poderosos, como o metano; as contribuições do dióxido de carbono de outras atividades humanas, como o desmatamento e a fabricação de cimento; uma melhor compreensão das propriedades de mudança na temperatura da poluição atmosférica, como emissões de enxofre e aerossóis, e sua importância no resfriamento do hemisfério norte pós-1940. A base de conhecimento estava aumentando ano após ano. Verificou-se que tanto as plantas quanto os oceanos tinham limites em relação à quantidade de dióxido de carbono poderiam incorporar em um determinado período de tempo. Os modelos computacionais estavam melhorando constantemente à medida que os parâmetros eram melhor entendidos. Em um artigo de 1981 na revista Nature, os climatologistas Tom Wigley e Phil Jones disseram: "Os efeitos do CO2 podem não ser detectáveis até a virada do século. A essa altura, sua concentração atmosférica provavelmente se tornará suficientemente alta (e estaremos empenhados em aumentá-la ainda mais) que uma mudança climática significativamente maior do que qualquer outra já ocorrida no passado poderá ser inevitável ".

Testemunhos de gelo e ar ancestral

A essa altura, a perfuração de testemunhos nos mantos de gelo da Groenlândia e da Antártica já havia se tornado um importante ramo da pesquisa do clima do passado. O gelo contém pequenas bolhas de ar pré-histórico capturadas quando da sua formação e, uma vez que um método confiável foi desenvolvido de forma a isolar e analisar esse ar (o que é feito no vácuo), foi possível ter uma ideia da composição da atmosfera do passado, ao longo dos períodos glaciais e interglaciais. Verificou-se que, nas profundezas congeladas da última idade do gelo, os níveis de dióxido de carbono eram muito menores, menos de duzentas partes por milhão. Em meados da década de 1980, o famoso testemunhos de gelo de Vostok foi perfurado a uma profundidade de 2 km, representando 150 mil anos de história climática, ou um ciclo completo interglacial-glacial-interglacial. As flutuações do dióxido de carbono mostraram uma relação notavelmente consistente com a temperatura.

Os dados dos testemunhos de gelo também demonstraram outro aspecto do papel dos gases de efeito estufa: a retroalimentação. Mesmo que os episódios de aquecimento fossem iniciados por mudanças orbitais, o próprio aquecimento causaria a liberação de gases de efeito estufa de fontes que incluem os oceanos e o derretimento do permafrost (solos congelados). Esses gases de efeito estufa adicionais funcionariam como amplificadores poderosos do aquecimento inicial. O inverso também pode ocorrer com a redução desses gases, facilitando o declínio da temperatura e um retorno para a idade do gelo. Mas, dado que os níveis de dióxido de carbono estavam agora substancialmente maiores do que em qualquer momento dos últimos dois milhões de anos, nos períodos glaciais ou interglaciais, ficou bastante claro que o efeito estufa era algo que precisávamos levar a sério: mesmo que o aumento da temperatura para o futuro ainda fosse quantitativamente desconhecido e com um intervalo de erro considerável, os modelos indicavam que uma duplicação do dióxido de carbono em relação aos níveis pré-industriais provavelmente resultaria em um aumento de três graus celsius na média global.

Outra área de interesse na pesquisa foi a das mudanças climáticas de grande escala no passado distante (tempo geológico). Uma vez que a tectônica de placas foi compreendida, tornou-se possível, usando toda uma série de técnicas geológicas, retraçar a deriva dos continentes ao longo de centenas de milhões de anos. Essas reconstruções paleogeográficas demonstraram que em certos períodos do passado, alguns dos quais com dezenas de milhões de anos de duração, a distribuição da flora e da fauna no registro fóssil indicava espécies de climas quentes existindo em uma extensão latitudinal muito maior que nos dias atuais. O planeta como um todo deve ter desfrutado de um clima muito mais quente, com os polos especialmente quentes em comparação com os últimos tempos. Agora que a relação dióxido de carbono-temperatura estava se tornando bem compreendida, a atenção foi voltada para esses períodos quentes do passado, e evidências de que os níveis de dióxido de carbono haviam sido realmente muito maiores nesses períodos começaram a se acumular.

Resolvendo o paradoxo do jovem Sol fraco

Essa descoberta também respondeu a outro problema geológico: o do chamado "Paradoxo do jovem Sol fraco". Desde muito tempo os astrofísicos já sabiam que o Sol era uma estrela da Sequência Principal, que tinha aumentado seu brilho progressivamente em cerca de 10% a cada bilhão de anos, de modo que era consideravelmente menos brilhante nos primórdios do universo. Os geólogos conheciam algumas glaciações bastante difundidas no passado: houve uma idade do gelo no final do período Ordoviciano, há cerca de 445 milhões de anos, e, voltando no tempo, houve algumas eras glaciais gigantes, talvez globais, no éon Proterozóico. Os últimos eventos ficaram registrados em sequências de rochas características, tipicamente constituídas por tillitos (que representam o acúmulo de detritos carregados por uma geleira), cobertos por carbonatos (sedimentos químicos de origem marinha depositados durante os períodos interglaciais após um período de aumento do nível do mar). Mas, apesar desse sol mais fraco, e fora destes períodos glaciais, o clima tinha sido mais quente do que deveria.

O cartão de visitas de uma antiga era glacial - um afloramento na Namíbia de sedimentos glaciogênicos antigos (proterozóicos), cobertos por uma sequência dolomítica de carbonatos de origem marinha, depositados em condições pós-glaciais mais quentes. Foto: P. Hoffman.

1980: O Ciclo do Carbono – o termostato da Terra

Compreender o ciclo do carbono foi fundamental para explicar isso: a constatação foi de que, ao longo do tempo geológico, os níveis de dióxido de carbono e outros gases de efeito estufa haviam exercido grande controle sobre a temperatura planetária. O dióxido de carbono tinha fontes e sumidouros reguladores, mas de vez em quando havia grandes alterações nesse ciclo, quando fontes ou sumidouros excepcionalmente poderosos dominavam a cena. Esses distúrbios foram registrados nos estratos das rochas. As principais fontes, como episódios de atividade vulcânica excepcional, cobrindo áreas quase continentais com lavas e tufos, deixaram seus cartões de visita para os geólogos examinarem. Os principais sumidouros também: à medida que os continentes colidiam, as montanhas foram sendo formadas, deixando quantidades fenomenais de detritos de rocha disponíveis aos agentes meteorológicos, dos quais o dióxido de carbono dissolvido na água da chuva é um dos mais importantes. Esses distúrbios ocasionais resultaram em episódios climáticos mais quentes e mais frios, respectivamente. Era como se esses gases de efeito estufa atuassem como um termostato do planeta.

Reconstruções climáticas do passado mostraram que as temperaturas nesses períodos tinham sido em torno de seis graus mais quentes, em média que nos tempos atuais. Maiores diferenças foram observadas para as regiões polares, sem a presença de calotas polares e com uma fauna e flora características de regiões temperadas a subtropicais, como evidenciado pelo registro fóssil dessas áreas. Mas há uma diferença muito importante entre o passado e o presente: a taxa de flutuações nos níveis de dióxido de carbono atmosférico no passado tinha a velocidade de um caracol quando comparada aos aumentos recentes – e os níveis atuais continuam a subir de forma exponencial – cada vez mais rápido. Além disso, mudanças ambientais muito bruscas (ao longo de algumas dezenas de milhares de anos) no passado geológico foram muitas vezes acompanhadas de extinções em massa pois ocorreram de forma tão rápida que os ecossistemas não conseguiram se adaptar a elas. Foi em meio a tais descobertas que o Painel Intergovernamental sobre Mudanças Climáticas foi criado, em 1988.

No início do século XXI, os sérios riscos associados ao contínuo ajuste no termostato do planeta tornaram-se evidentes. Eles incluíam uma ampla gama de problemas: secas severas e sem precedentes que afetaram a agricultura em algumas áreas, inflacionando os preços mundiais dos alimentos e também tornando as condições propícias aos incêndios florestais; em outras áreas, aumento dos eventos de precipitação extrema, levando a inundações generalizadas, destruição de culturas agrícolas, perdas/danos em propriedades e até mesmo mortes. O aumento do nível do mar ao longo das próximas décadas afetará a agricultura devido à perda de terras férteis próximas ao nível do mar e também levará ao deslocamento da população e à migração em massa continente adentro. Em resumo, a humanidade está ocupada em criar áreas da superfície do planeta inabitáveis para as gerações futuras.

A oposição à ciência se faz presente

Importante também ressaltar que a década de 1990 presenciou o surgimento de organizações politicamente orientadas e bem financiadas que promovem a oposição à ciência do clima, sendo uma das primeiras a Information Council on the Environment, de 1991. No final da década, também havia a American Petroleum Institute com seu “Plano de Ação de Comunicação Global da Ciência do Clima”, de 1998, do qual um trecho pode ser visto abaixo (uma cópia em pdf pode ser encontrada em climatesciencewatch.org). Essa foi uma campanha destinada, principalmente, a responder as questões ligadas ao limite de emissões do Protocolo de Kyoto, assinado em dezembro de 1997.

A Guerra política que se seguiu desde então deve ser familiar à maioria dos leitores, e a ciência do clima mais recente, do final do século XX e início do XXI, tem tido uma cobertura ampla tanto pelo site Skeptical Science, quanto por outros como o Realclimate. Os princípios básicos da ciência permanecem os mesmos, mas por todo mundo os detalhes vêm sendo aprimorados à medida que melhores métodos de coleta de dados são desenvolvidos, problemas com os padrões e marcadores ambientais (proxies - usados para entender as temperaturas do passado geológico) são resolvidos e o monitoramento aperfeiçoado. Mas Fourier, Tyndall e Arrhenius estavam definitivamente no caminho certo, há tantos anos atrás, quando seus trabalhos pioneiros começaram a descobrir o que faz o clima da Terra funcionar. Isso certamente é algo para lembrar se você estiver discutindo sobre mudanças climáticas com alguém e a pessoa disser que a ciência do clima só existe há algumas décadas!

Leitura adicional

A Descoberta do Aquecimento Global, de Spencer Weart, fornece uma descrição detalhada da história da ciência do clima com uma infinidade de referências – há muito tempo a ser dedicado ao estudo aprofundado para aqueles que querem ir além da blogosfera!

Traduzido por: Claudia Groposo e Luciano Marquetto

Translation by Luciano Marquetto. View original English version.

Arguments

Arguments